Robots协议,一个闲人免进的牌子

Robots协议提供了一种保护互联网内容和隐私的手段,借助该协议,实现了网站与搜索引擎之间的一种平衡,维护了正常的网络秩序.

□马少平

Robots协议是有关网络爬虫的一个协议,用于规范网络爬虫的行为,网站通过Robots协议告知爬虫哪些页面可以抓取,哪些页面不可以抓取。

Robots协议形成于1993年、1994年前后。当时,随着互联网的发展,网络上的内容越来越丰富,同时,一些早期的搜索引擎包括一些信息收集网站的发展,出现了不少网络爬虫,自动收集网络上的内容。在这种情况下,网站的所有者希望可以通过某种手段使自己网站上的全部或者部分内容不被抓取,以保护自己的权利或者隐私,而搜索引擎也希望可以合理地获取网络上的内容。为此,网站所有者和搜索引擎人员一起,通过邮件组开始讨论,共同起草了Robots协议。

Robots协议并不复杂,它主要是提供一些指令,通过这些指令表明自己网站的哪些内容可以被爬虫爬,或者哪些内容不能被爬,也可以指令允许哪些爬虫爬,不允许哪些爬虫爬,这也就是所谓的黑名单、白名单这样的方式。无论是黑名单还是白名单,都是保护网站内容的一种手段,可以单独使用白名单,也可以单独使用黑名单,或者两个一起用。就我所知,目前使用白名单相对比较多,因为这样对网站所有者比较方便,网站所有者可能不知道一共有多少爬虫,但是一些大的搜索引擎,比如百度、谷歌、搜狗,允许他们来爬,于是就设置出白名单,可能后期还有其他的搜索引擎需要爬取内容,他们可以通过与网站所有者协商的方式加入到白名单中,这可能就是白名单比较多的原因。

Robots协议经世界互联网技术邮件组发布以后,几乎得到了所有搜索引擎的认可。Robots协议虽然不是一个国际标准,但事实上已经成为了业内一种普遍遵守的规范。目前国际上大的搜索引擎均遵守该协议,比如国际上的雅虎、谷歌等,国内的百度、搜狗等。

网站的Robots协议内容以文本文件Robots.txt的方式放置在网站的根目录下,当一个爬虫访问某个网站时,首先到网站的根目录检查是否存在Robots.txt,如果存在,则按照其允许的内容进行抓取;如果不存在,则默认该网站全部内容可以抓取。另外,Robots协议从保护内容的角度说,它仅是一个声明并不是一种技术手段,也不是一种防止爬虫爬取内容的技术,而是一种所谓的防君子不防小人的手段,它从技术上无法阻挡某个爬虫抓取网站内容,只是一种声明,告诉爬虫可以抓取的内容。这就如同一个店家在门口挂了一个“闲人免进”的牌子,但是门是开着的,遵守的人看到“闲人免进”可能就不进入,但这无法阻止不遵守的人进入。

Robots协议在1993年、1994年前后被提出以后,业内都在遵守这一协议,说明它具有一定的合理性,就如同在车马路上行驶,大家都靠右行驶,如果有人看到左边有空就走左边势必会造成一种混乱。既然目前大家都遵守这样一个规则,那么这个秩序就形成了,如果容忍破坏者,那么这个秩序也就被破坏掉了。总之,Robots协议提供了一种保护互联网内容和隐私的手段,借助该协议,实现了网站与搜索引擎之间的一种平衡,维护了正常的网络秩序。

(作者为清华大学智能技术与系统国家重点实验室主任)

- 01-092023年的四大网络风险以及如何应对

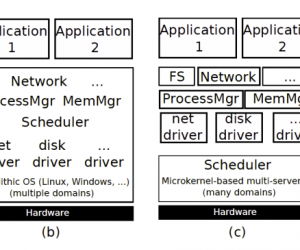

- 01-09操作系统/虚拟化安全知识域:攻击者模型

- 01-09操作系统/虚拟化安全知识域:操作系统及其设计在安全中的作用

- 01-092022年全球勒索赎金TOP 10

- 03-06俄乌冲突快讯:乌克兰网站被攻击数量超十倍

- 02-23开放式银行创新:开发人员与网络犯罪分子之间的竞赛

- 02-23数据泄露后信息会怎样?

- 02-23四个首创 冬奥网络安全“黑科技”面面观

- 01-11全球最受赞誉公司揭晓:苹果连续九年第一

- 12-09罗伯特·莫里斯:让黑客真正变黑

- 12-09谁闯入了中国网络?揭秘美国绝密黑客小组TA

- 12-09警示:iOS6 惊现“闪退”BUG

- 11-18LG新能源宣布与Bear Robotics达成合作,成为

- 11-18机构:三季度全球个人智能音频设备市场强势

- 11-18闲鱼:注册用户过6亿 AI技术已应用于闲置交

- 11-18美柚、宝宝树回应“涉黄短信骚扰”:未发现

- 11-01京东七鲜与前置仓完成融合

粤公网安备 44060402001498号

粤公网安备 44060402001498号